신경망 학습 진행 과정

1. 데이터가 입력되면 신경망 각 층에서 가중치 및 활성화 함수 연산을 반복적으로 수행

2. 1의 과정을 모든 층에서 반복한 후에 출력층에서 계산된 값을 출력

3. 손실 함수를 사용하여 예측값(Prediction)과 실제값(Target)의 차이 계산

4. 경사하강법과 역전파를 통해서 각 가중치를 갱신

5. 학습 중지 기준을 만족할 때까지 1~4의 과정을 반복

1 ~ 4 과정을 Iteration(이터레이션) 이라고 하며 매 Iteration 마다 가중치가 갱신

순전파, 손실 계산, 역전파로 나누어짐

- 순전파: 예측하기

- 손실 함수: 실제 값과의 차이 계산

- 역전파: 가중치 수정

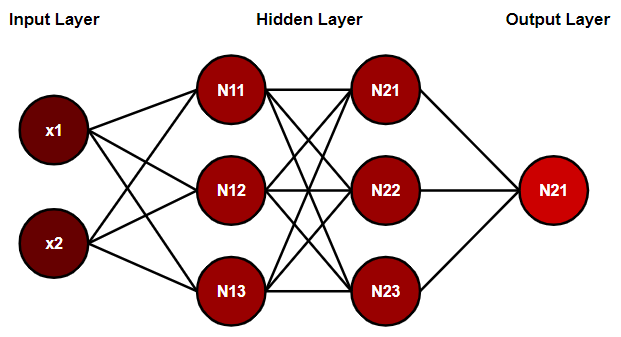

순전파(Forward Propagation)

입력층에서 입력된 신호가 은닉층의 연산을 거쳐 출력층에서 값을 내보내는 과정

연산 과정

1. 입력층으로부터 신호 전달

2. 입력된 데이터에 가중치-편향 연산 수행

3. 가중합을 통해 구해진 값은 활성화 함수를 통해 다음 층으로 전달

손실 함수(Loss function)

신경망은 손실 함수를 최소하 하는 방향으로 가중치 갱신

입력 데이터를 신경망에 넣어 순전파를 거치면 마지막에 출력층을 통과한 값이 도출

이 때 출력된 값과 그 데이터의 타겟값을 손실 함수에 넣어 손실(Loss or Error)를 계산

대표적인 손실 함수

MSE(Mean-Squared Error), CEE(Cross-Entropy Error)

역전파(Backward Propagation)

순전파와는 반대 방향으로 손실(Loss or Error) 정보를 전달해주는 과정

구해진 손실 정보를 출력층부터 입력층까지 전달하여 각 가중치를 얼마나 업데이트 히야할지를 구하는 알고리즘

신경망은 매 Iteration 마다 손실(Loss)을 줄이는 방향으로 가중치 업데이터

가중치 수정 방향을 결정하는 것은 경사 하강법(Gradient Descent, GD)

'IT' 카테고리의 다른 글

| 옵티마이저(Optimizer) (0) | 2022.06.04 |

|---|---|

| 경사 하강법(Gradient Descent) (0) | 2022.06.03 |

| 기울기 소실 (0) | 2022.06.01 |

| 활성화 함수(Activation Function)의 공통점 (0) | 2022.05.31 |

| 가중치 행렬 (0) | 2022.05.30 |