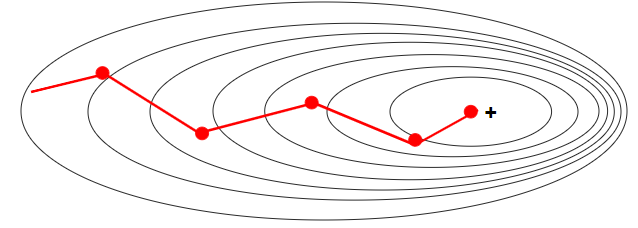

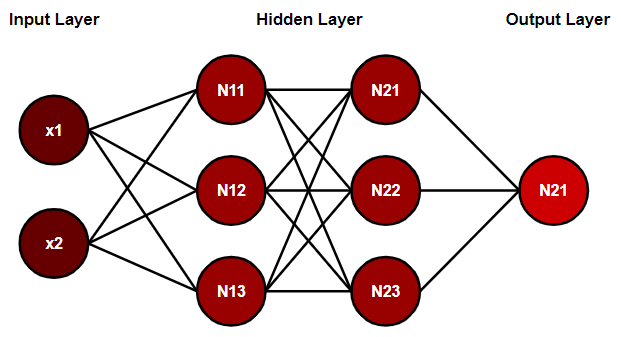

model.compile(optimizer = tf.keras.optimizers.Adam(learning_rate = lr_decayed_fn) , loss = 'sparse_categorical_crossentropy' , metrics = ['accuracy'] 신경망 학습이 더 잘되도록 하는 방법 학습률(Learning rate, lr) 매 가중치에 대해 구해진 기울기 값을 얼마나 경사 하강법에 적용할지를 결정하는 하이퍼파라미터 해당 지점에서의 기울기를 구하여 기울기가 감소하는 방향으로 이동 학습률은 얼마나 이동할지를 조정하는 하이퍼파라미터 경사 하강법이 산길을 내려가는 과정이라면 학습률은 보폭을 결정 학습률이 크면 보폭이 크니 Iteration 마다 성큼성큼 이동하고, 작으면 보폭이 작아 조금씩..